- Esenciales

- Empezando

- Datadog

- Sitio web de Datadog

- DevSecOps

- Serverless para Lambda AWS

- Agent

- Integraciones

- Contenedores

- Dashboards

- Monitores

- Logs

- Rastreo de APM

- Generador de perfiles

- Etiquetas (tags)

- API

- Catálogo de servicios

- Session Replay

- Continuous Testing

- Monitorización Synthetic

- Gestión de incidencias

- Monitorización de bases de datos

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Análisis de código

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Uso básico del Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Configuración remota

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- OpenTelemetry

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un cuadro

- Crear un dashboard de integración

- Crear un monitor recomendado

- Crear una regla de detección Cloud SIEM

- OAuth para integraciones

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- Administrator's Guide

- API

- Aplicación móvil de Datadog

- CoScreen

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Hojas

- Monitores y alertas

- Infraestructura

- Métricas

- Watchdog

- Bits AI

- Catálogo de servicios

- Catálogo de APIs

- Error Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Gestión de eventos

- Gestión de casos

- Workflow Automation

- App Builder

- Infraestructura

- Universal Service Monitoring

- Contenedores

- Serverless

- Monitorización de red

- Coste de la nube

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Observabilidad del servicio

- Instrumentación dinámica

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Experiencia digital

- Real User Monitoring

- Monitorización del navegador

- Configuración

- Configuración avanzada

- Datos recopilados

- Monitorización del rendimiento de páginas

- Monitorización de signos vitales de rendimiento

- Monitorización del rendimiento de recursos

- Recopilación de errores del navegador

- Rastrear las acciones de los usuarios

- Señales de frustración

- Error Tracking

- Solucionar problemas

- Monitorización de móviles y TV

- Plataforma

- Session Replay

- Exploración de datos de RUM

- Feature Flag Tracking

- Error Tracking

- Guías

- Seguridad de los datos

- Monitorización del navegador

- Análisis de productos

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Entrega de software

- CI Visibility

- CD Visibility

- Test Visibility

- Configuración

- Tests en contenedores

- Búsqueda y gestión

- Explorador

- Monitores

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Detección temprana de defectos

- Reintentos automáticos de tests

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- Métricas de DORA

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Sensitive Data Scanner

- Ayuda

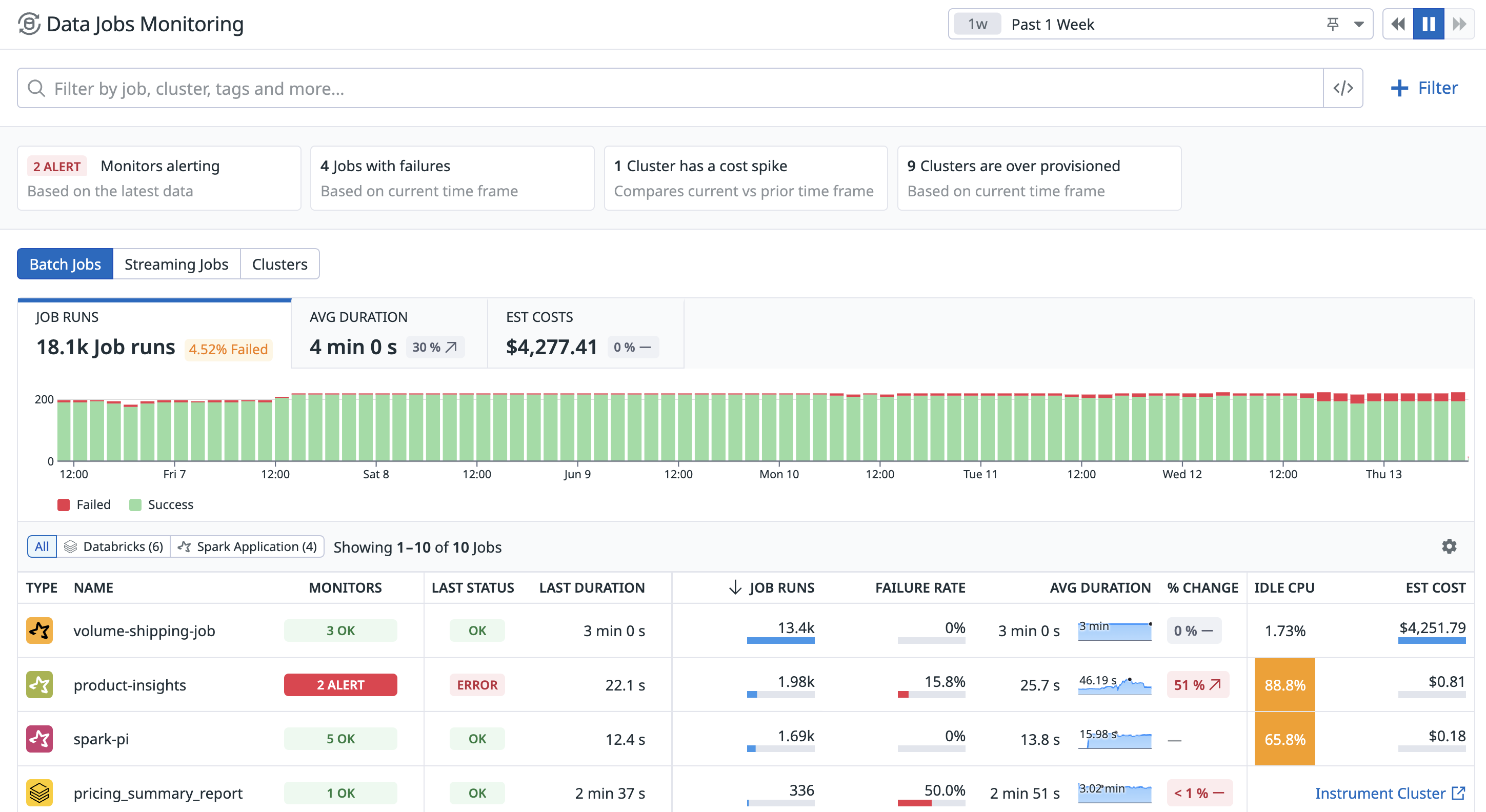

Data Jobs Monitoring

Data Jobs Monitoring proporciona visibilidad del rendimiento, la fiabilidad y la rentabilidad de tus trabajos de procesamiento de datos, junto con la infraestructura subyacente. Data Jobs Monitoring te permite:

- Realizar un seguimiento del estado y el rendimiento de los trabajos de procesamiento de datos en todas tus cuentas y espacios de trabajo. Descubre cuáles consumen más recursos informáticos o presentan ineficiencias.

- Recibir una alerta cuando falla un trabajo o cuando tarda demasiado en finalizar.

- Analizar detalles y trazas (traces) de stack tecnológico de la ejecución del trabajo.

- Correlacionar métricas de infraestructura, métricas de Spark desde la interfaz de usuario de Spark, logs y configuraciones de clústeres.

- Comparar varias ejecuciones para facilitar la resolución de problemas y optimizar el suministro y la configuración durante el despliegue.

Ajustes

Data Jobs Monitoring es compatible con la monitorización de trabajos en Amazon EMR, Databricks (AWS, Azure, Google Cloud), Google Dataproc, Spark en Kubernetes, y Apache Airflow.

Para empezar, selecciona tu plataforma y sigue las instrucciones de instalación:

Explorar Data Jobs Monitoring

Identificar fácilmente los trabajos poco fiables e ineficaces

Visualiza todos los trabajos en todas las cuentas en la nube y espacios de trabajo. Identifica los trabajos fallidos para tomar medidas al respecto o encuentra trabajos con un elevado nivel de CPU inactiva que estén utilizando mucho cálculo y deban optimizarse.

Recibir alertas sobre trabajos problemáticos

Los monitores Datadog envían alertas cuando un trabajo falla o se está ejecutando más allá de su tiempo de finalización. Consulta plantillas de monitor para monitorizar trabajos de datos específicos de tu integraciones instalada.

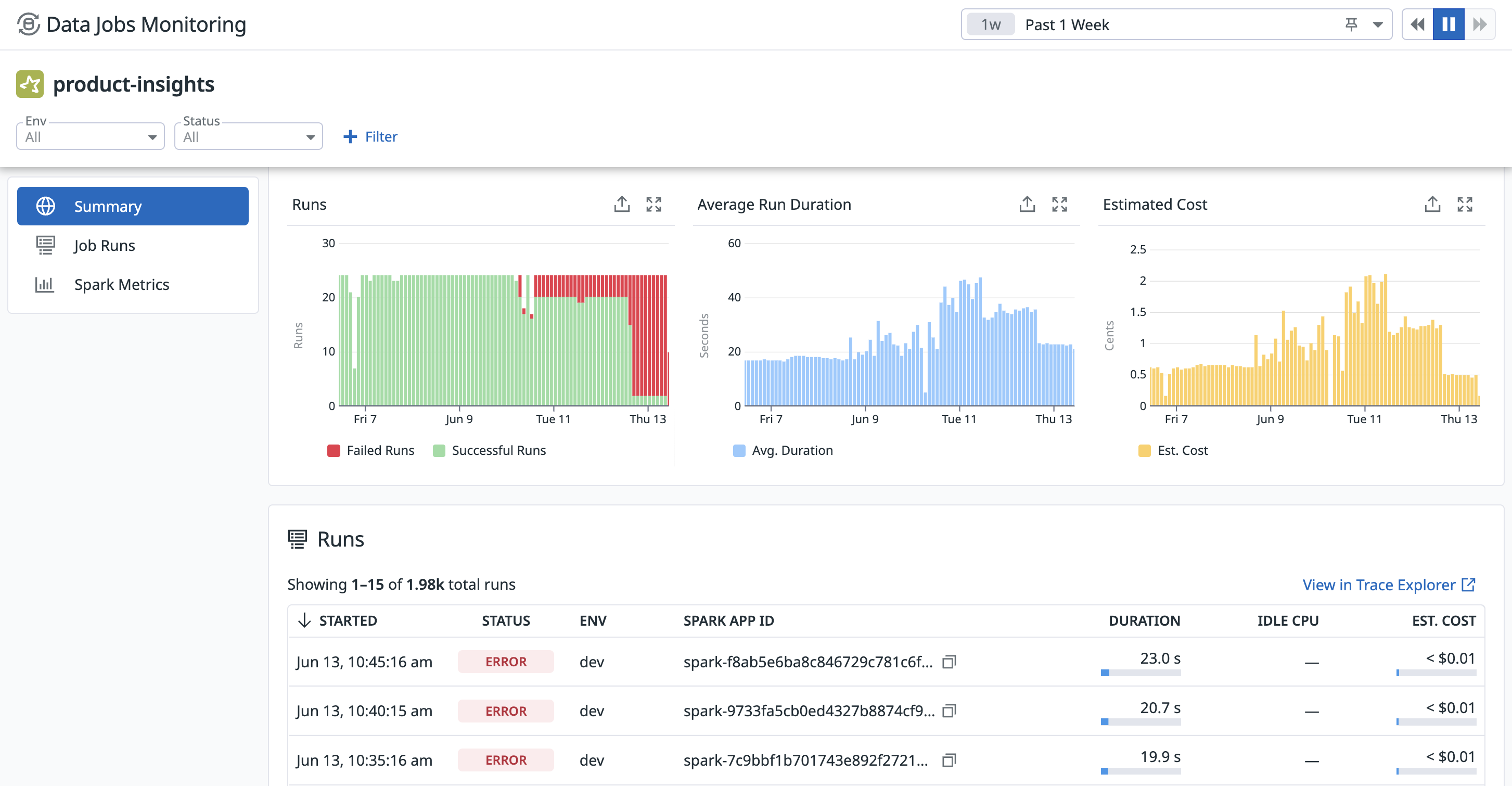

Analizar y solucionar problemas de trabajos individuales

Haz clic en un trabajo para ver su rendimiento en varias ejecuciones, así como los mensajes de error de las ejecuciones fallidas.

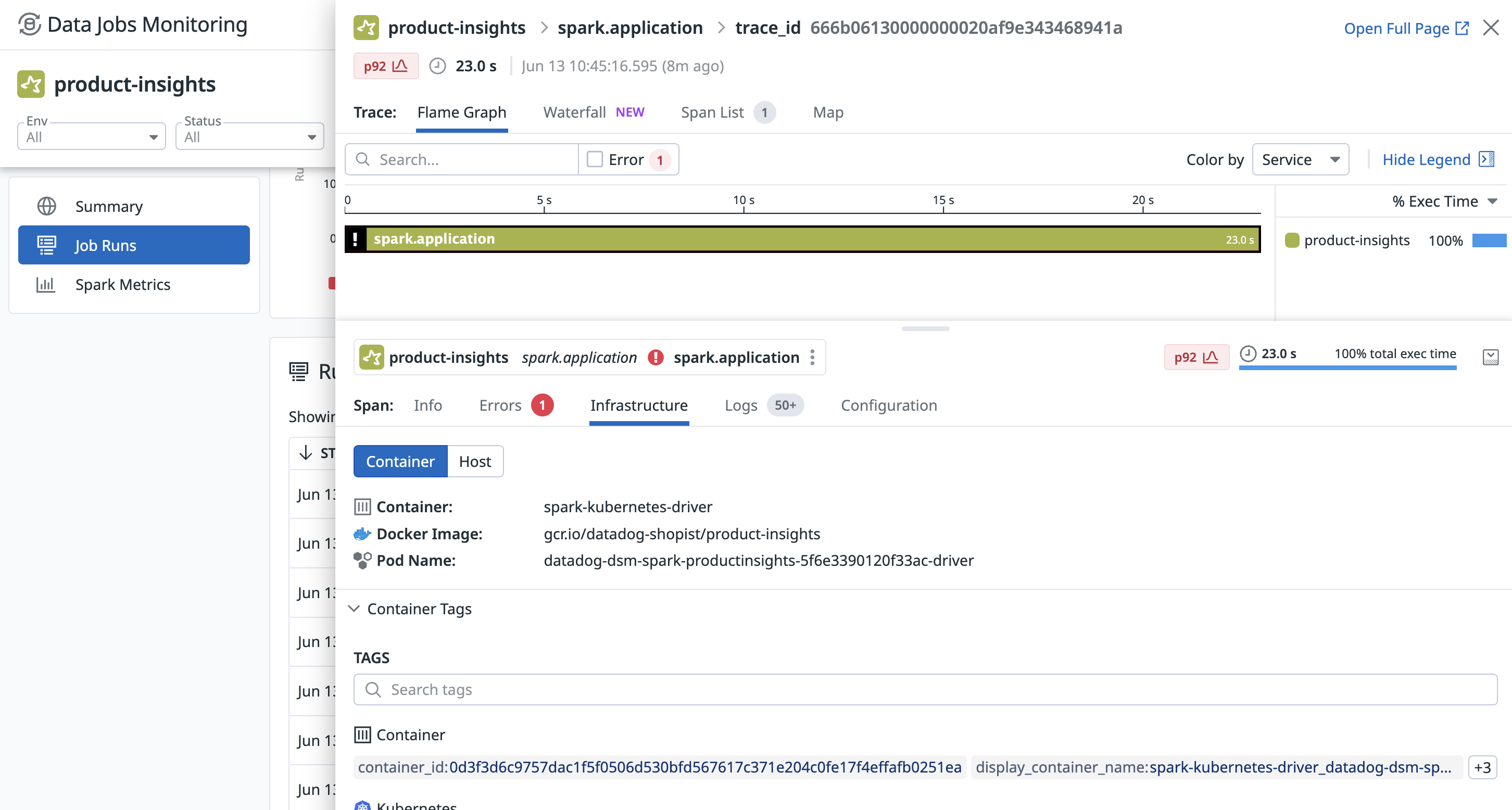

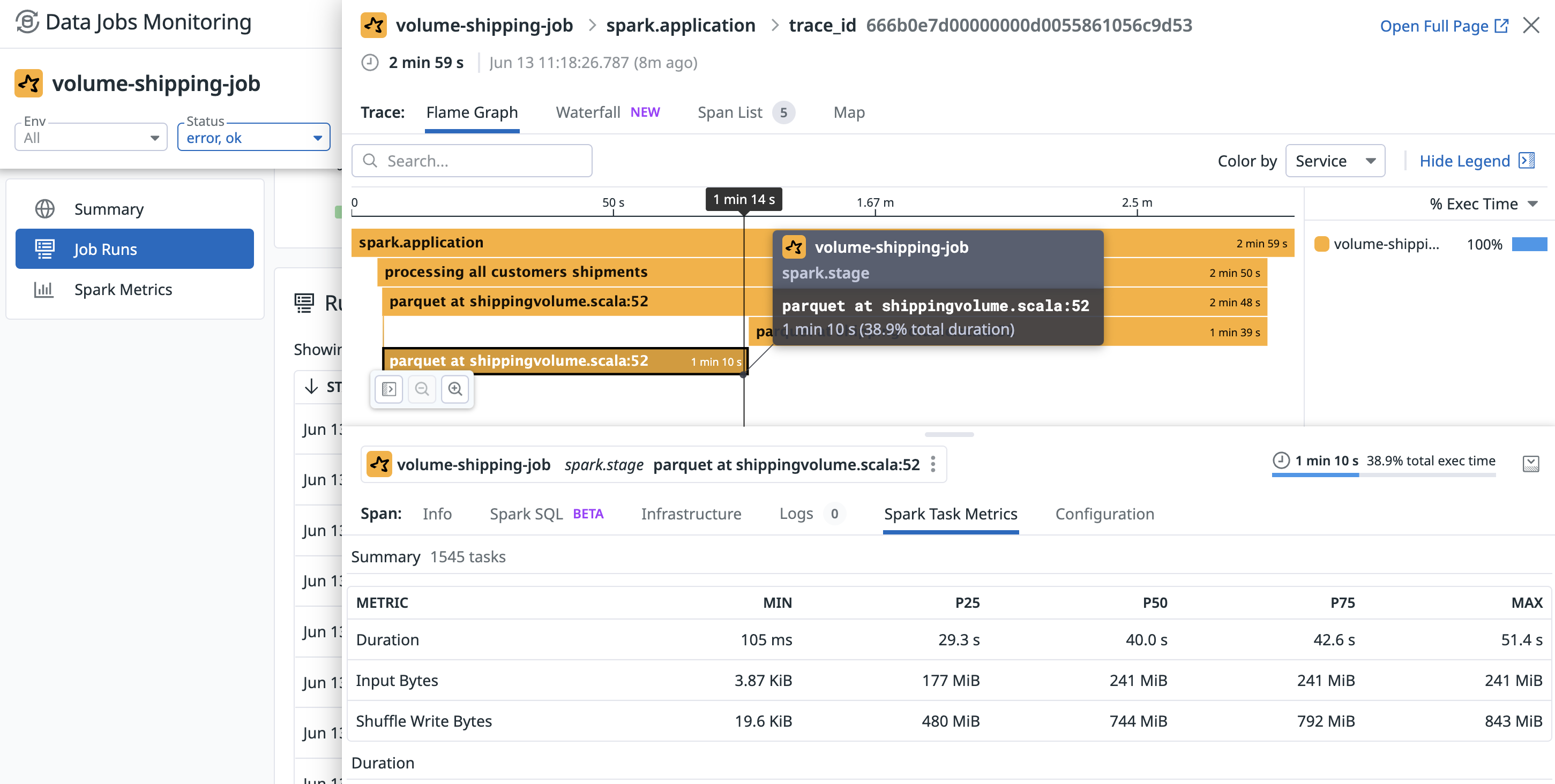

Analizar una ejecución individual

Al hacer clic en una ejecución, se abre un panel lateral con detalles de la cantidad de tiempo que se empleó en cada trabajo y etapa de Spark, junto con un desglose del consumo de recursos y métricas de Spark, como la CPU inactiva del ejecutor, el volumen de datos de entrada/salida, la mezcla de datos y el desbordamiento del disco. Desde este panel puedes correlacionar la ejecución con el uso de recursos del nodo del ejecutor y el controlador, los logs, y la configuración del trabajo y el clúster.

En la pestaña Infraestructura puedes correlacionar la ejecución con métricas de infraestructura.

En el caso de una ejecución fallida, consulta la pestaña Errores para ver la traza de stack tecnológico, que puede ayudarte a determinar dónde y cómo se produjo el fallo.

Para determinar por qué una etapa tarda mucho tiempo en finalizar, puedes utilizar la pestaña Métricas de tareas Spark para ver las métricas a nivel de tarea de una etapa específica de Spark y poder identificar el sesgo de los datos. Visualiza la distribución del tiempo empleado y de los datos consumidos por las distintas tareas.

Para leer más

Más enlaces, artículos y documentación útiles: