- Esenciales

- Empezando

- Datadog

- Sitio web de Datadog

- DevSecOps

- Serverless para Lambda AWS

- Agent

- Integraciones

- Contenedores

- Dashboards

- Monitores

- Logs

- Rastreo de APM

- Generador de perfiles

- Etiquetas (tags)

- API

- Catálogo de servicios

- Session Replay

- Continuous Testing

- Monitorización Synthetic

- Gestión de incidencias

- Monitorización de bases de datos

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Análisis de código

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Uso básico del Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Configuración remota

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- OpenTelemetry

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un cuadro

- Crear un dashboard de integración

- Crear un monitor recomendado

- Crear una regla de detección Cloud SIEM

- OAuth para integraciones

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- Administrator's Guide

- API

- Aplicación móvil de Datadog

- CoScreen

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Hojas

- Monitores y alertas

- Infraestructura

- Métricas

- Watchdog

- Bits AI

- Catálogo de servicios

- Catálogo de APIs

- Error Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Gestión de eventos

- Gestión de casos

- Workflow Automation

- App Builder

- Infraestructura

- Universal Service Monitoring

- Contenedores

- Serverless

- Monitorización de red

- Coste de la nube

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Observabilidad del servicio

- Instrumentación dinámica

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Experiencia digital

- Real User Monitoring

- Monitorización del navegador

- Configuración

- Configuración avanzada

- Datos recopilados

- Monitorización del rendimiento de páginas

- Monitorización de signos vitales de rendimiento

- Monitorización del rendimiento de recursos

- Recopilación de errores del navegador

- Rastrear las acciones de los usuarios

- Señales de frustración

- Error Tracking

- Solucionar problemas

- Monitorización de móviles y TV

- Plataforma

- Session Replay

- Exploración de datos de RUM

- Feature Flag Tracking

- Error Tracking

- Guías

- Seguridad de los datos

- Monitorización del navegador

- Análisis de productos

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Entrega de software

- CI Visibility

- CD Visibility

- Test Visibility

- Configuración

- Tests en contenedores

- Búsqueda y gestión

- Explorador

- Monitores

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Detección temprana de defectos

- Reintentos automáticos de tests

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- Métricas de DORA

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Sensitive Data Scanner

- Ayuda

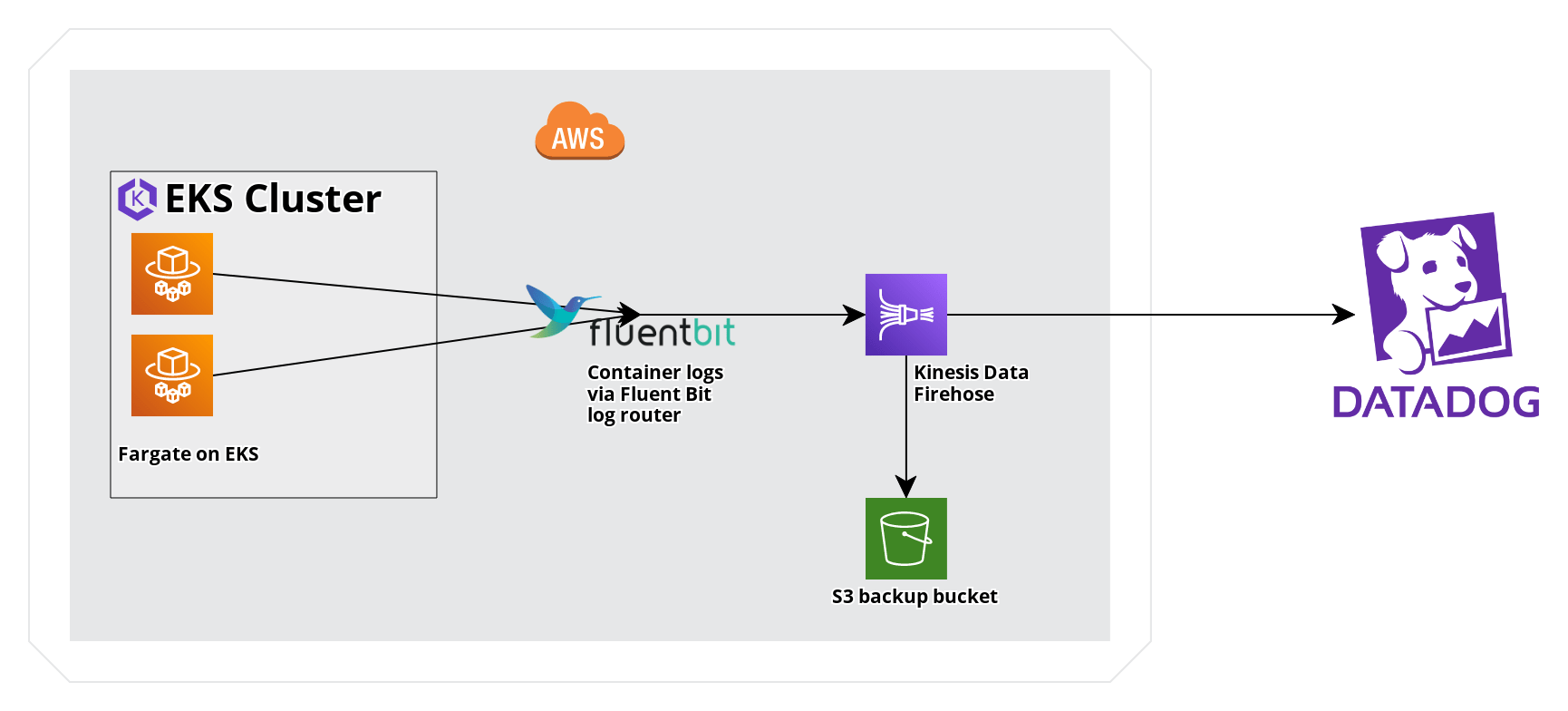

Enviar logs de Amazon EKS Fargate con Amazon Data Firehose

Información general

AWS Fargate en EKS proporciona una experiencia totalmente gestionada de ejecución de cargas de trabajo Kubernetes. Amazon Data Firehose puede utilizarse junto con el enrutador de logs Fluent Bit de EKS para recopilar logs en Datadog. Esta guía proporciona una comparación del reenvío de logs a través de Amazon Data Firehose y de CloudWatch, así como una aplicación de ejemplo de EKS Fargate para el reenvío de logs a Datadog a través de Amazon Data Firehose.

Reenvío de logs con Amazon Data Firehose y CloudWatch

A continuación se indican las principales diferencias entre el uso de Amazon Data Firehose y CloudWatch para el reenvío de logs.

Metadatos y etiquetado: los metadatos, como el espacio de nombres y el ID de contenedor Kubernetes, son accesibles como atributos estructurados cuando se envían logs a través de Amazon Data Firehose.

Costes de AWS: los costes de AWS pueden variar según los casos de uso individuales, pero el consumo de Amazon Data Firehose suele ser menos costoso que el consumo de logs comparable de CloudWatch.

Requisitos

- Las siguientes herramientas de línea de comandos:

kubectl,aws. - Un clúster EKS con un perfil de Fargate y un rol de ejecución del pod Fargate. En esta guía, el clúster se denomina

fargate-cluster, con un perfil de Fargate denominadofargate-profileaplicado al espacio de nombresfargate-namespace. Si aún no dispones de estos recursos, consulta Empezando con Amazon EKS, para crear el clúster, y Empezando con AWS Fargate utilizando Amazon EKS, para crear el perfil de Fargate y el rol de ejecución del pod.

Configuración

Los siguientes pasos describen el proceso para el envío de logs desde una aplicación de ejemplo desplegada en un clúster EKS a través de Fluent Bit, y de un flujo (stream) de entrega de Amazon Data Firehose a Datadog. Para maximizar la coherencia con las etiquetas (tags) estándar de Kubernetes en Datadog, se incluyen instrucciones para reasignar atributos seleccionados a claves de etiqueta.

- Crea un flujo de entrega de Amazon Data Firehose que entregue logs a Datadog, junto con una copia de seguridad de S3 para cualquier entrega de logs fallida.

- Configura Fluent Bit para Firehose en EKS Fargate.

- Despliega una aplicación de ejemplo.

- Aplica procesadores de reasignadores para la correlación utilizando etiquetas de Kubernetes y la etiqueta

container_id.

Crear un flujo de entrega de Amazon Data Firehose

Consulta la guía Enviar logs de servicios AWS con Amazon Data Firehose de Datadog como destino para configurar un flujo de entrega de Amazon Data Firehose.

Nota: Configura la Fuente como Direct PUT.

Configurar Fluent Bit para Firehose en un clúster EKS Fargate

- Crea el espacio de nombres

aws-observability.

kubectl create namespace aws-observability- Crea el siguiente ConfigMap Kubernetes para Fluent Bit como

aws-logging-configmap.yaml. Sustituye el nombre de tu flujo de entrega.

Para el nuevo complemento Kinesis Firehose de mayor rendimiento, utiliza el nombre del complemento

kinesis_firehose en lugar de amazon_data_firehose.apiVersion: v1

kind: ConfigMap

metadata:

name: aws-logging

namespace: aws-observability

data:

filters.conf: |

[FILTER]

Name kubernetes

Match kube.*

Merge_Log On

Buffer_Size 0

Kube_Meta_Cache_TTL 300s

flb_log_cw: 'true'

output.conf: |

[OUTPUT]

Name kinesis_firehose

Match kube.*

region <REGION>

delivery_stream <YOUR-DELIVERY-STREAM-NAME> - Utiliza

kubectlpara aplicar el manifiesto ConfigMap.

kubectl apply -f aws-logging-configmap.yaml- Crea una política IAM y adjúntala al rol de ejecución del pod para permitir que el enrutador de logs que se ejecuta en AWS Fargate escriba en Amazon Data Firehose. Puedes utilizar el siguiente ejemplo, sustituyendo el ARN en el campo Resource (Recurso) por el ARN de tu flujo de entrega y también especificando tu región o tu ID de cuenta.

allow_firehose_put_permission.json

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "VisualEditor0",

"Effect": "Allow",

"Action": [

"firehose:PutRecord",

"firehose:PutRecordBatch"

],

"Resource":

"arn:aws:firehose:<REGION>:<ACCOUNTID>:deliverystream/<DELIVERY-STREAM-NAME>"

}

]

}a. Crea la política.

aws iam create-policy \

--policy-name FluentBitEKSFargate \

--policy-document file://allow_firehose_put_permission.jsonb. Recupera el rol de ejecución del pod Fargate y adjunta la política IAM.

POD_EXEC_ROLE=$(aws eks describe-fargate-profile \

--cluster-name fargate-cluster \

--fargate-profile-name fargate-profile \

--query 'fargateProfile.podExecutionRoleArn' --output text |cut -d '/' -f 2)

aws iam attach-role-policy \

--policy-arn arn:aws:iam::<ACCOUNTID>:policy/FluentBitEKSFargate \

--role-name $POD_EXEC_ROLEDesplegar una aplicación de ejemplo

Para generar logs y probar el flujo de entrega de Amazon Data Firehose, despliega un ejemplo de carga de trabajo en tu clúster EKS Fargate.

- Crea un manifiesto de despliegue

sample-deployment.yaml.

sample-deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: sample-app

namespace: fargate-namespace

spec:

selector:

matchLabels:

app: nginx

replicas: 1

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx

ports:

- containerPort: 80- Crea el espacio de nombres

fargate-namespace.

kubectl create namespace fargate-namespace

- Utiliza

kubectlpara aplicar el manifiesto del despliegue.

kubectl apply -f sample-deployment.yaml

Validación

- Comprueba que los pods

sample-appse están ejecutando en el espacio de nombresfargate-namespace.

kubectl get pods -n fargate-namespace

Resultado esperado:

NAME READY STATUS RESTARTS AGE

sample-app-6c8b449b8f-kq2qz 1/1 Running 0 3m56s

sample-app-6c8b449b8f-nn2w7 1/1 Running 0 3m56s

sample-app-6c8b449b8f-wzsjj 1/1 Running 0 3m56s

- Utiliza

kubectl describe podpara confirmar que la función de gestión de logs de Fargate está habilitada.

kubectl describe pod <POD-NAME> -n fargate-namespace |grep Logging

Resultado esperado:

Logging: LoggingEnabled

Normal LoggingEnabled 5m fargate-scheduler Successfully enabled logging for pod

- Inspecciona los logs del despliegue.

kubectl logs -l app=nginx -n fargate-namespace

Resultado esperado:

/docker-entrypoint.sh: Launching /docker-entrypoint.d/30-tune-worker-processes.sh

/docker-entrypoint.sh: Configuration complete; ready for start up

2023/01/27 16:53:42 [notice] 1#1: using the "epoll" event method

2023/01/27 16:53:42 [notice] 1#1: nginx/1.23.3

2023/01/27 16:53:42 [notice] 1#1: built by gcc 10.2.1 20210110 (Debian 10.2.1-6)

2023/01/27 16:53:42 [notice] 1#1: OS: Linux 4.14.294-220.533.amzn2.x86_64

2023/01/27 16:53:42 [notice] 1#1: getrlimit(RLIMIT_NOFILE): 1024:65535

2023/01/27 16:53:42 [notice] 1#1: start worker processes

...

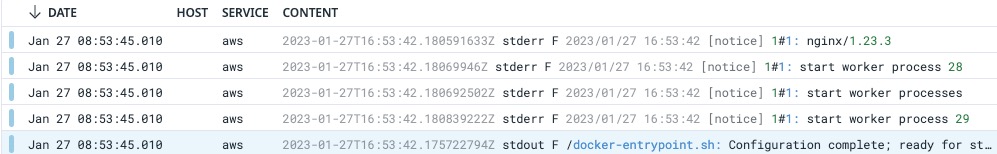

- Comprueba que los logs están en Datadog. En el Explorador de logs de Datadog, busca

@aws.firehose.arn:"<ARN>", sustituyendo<ARN>por tu ARN de Amazon Data Firehose, para filtrar logs desde Amazon Data Firehose.

Reasignar atributos para la correlación de logs

Los logs de esta configuración requieren la reasignación de algunos atributos para maximizar la coherencia con las etiquetas estándar de Kubernetes en Datadog.

Ve a la página Pipelines de logs de Datadog.

Crea un nuevo pipeline con el Nombre

EKS Fargate Log Pipeliney el Filtroservice:aws source:aws.Crea cuatro procesadores de reasignadores para reasignar los siguientes atributos a claves de etiqueta:

Atributo a reasignar Claves de etiqueta de destino kubernetes.container_namekube_container_namekubernetes.namespace_namekube_namespacekubernetes.pod_namepod_namekubernetes.docker_idcontainer_idDespués de crear este pipeline, los logs emitidos por la aplicación de ejemplo se etiquetan como en este ejemplo con los atributos de logs reasignados a etiquetas de Kubernetes:

Referencias adicionales

Más enlaces, artículos y documentación útiles: