- Esenciales

- Empezando

- Datadog

- Sitio web de Datadog

- DevSecOps

- Serverless para Lambda AWS

- Agent

- Integraciones

- Contenedores

- Dashboards

- Monitores

- Logs

- Rastreo de APM

- Generador de perfiles

- Etiquetas (tags)

- API

- Catálogo de servicios

- Session Replay

- Continuous Testing

- Monitorización Synthetic

- Gestión de incidencias

- Monitorización de bases de datos

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Análisis de código

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Uso básico del Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Configuración remota

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- OpenTelemetry

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un cuadro

- Crear un dashboard de integración

- Crear un monitor recomendado

- Crear una regla de detección Cloud SIEM

- OAuth para integraciones

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- Administrator's Guide

- API

- Aplicación móvil de Datadog

- CoScreen

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Hojas

- Monitores y alertas

- Infraestructura

- Métricas

- Watchdog

- Bits AI

- Catálogo de servicios

- Catálogo de APIs

- Error Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Gestión de eventos

- Gestión de casos

- Workflow Automation

- App Builder

- Infraestructura

- Universal Service Monitoring

- Contenedores

- Serverless

- Monitorización de red

- Coste de la nube

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Observabilidad del servicio

- Instrumentación dinámica

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Experiencia digital

- Real User Monitoring

- Monitorización del navegador

- Configuración

- Configuración avanzada

- Datos recopilados

- Monitorización del rendimiento de páginas

- Monitorización de signos vitales de rendimiento

- Monitorización del rendimiento de recursos

- Recopilación de errores del navegador

- Rastrear las acciones de los usuarios

- Señales de frustración

- Error Tracking

- Solucionar problemas

- Monitorización de móviles y TV

- Plataforma

- Session Replay

- Exploración de datos de RUM

- Feature Flag Tracking

- Error Tracking

- Guías

- Seguridad de los datos

- Monitorización del navegador

- Análisis de productos

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Entrega de software

- CI Visibility

- CD Visibility

- Test Visibility

- Configuración

- Tests en contenedores

- Búsqueda y gestión

- Explorador

- Monitores

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Detección temprana de defectos

- Reintentos automáticos de tests

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- Métricas de DORA

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Sensitive Data Scanner

- Ayuda

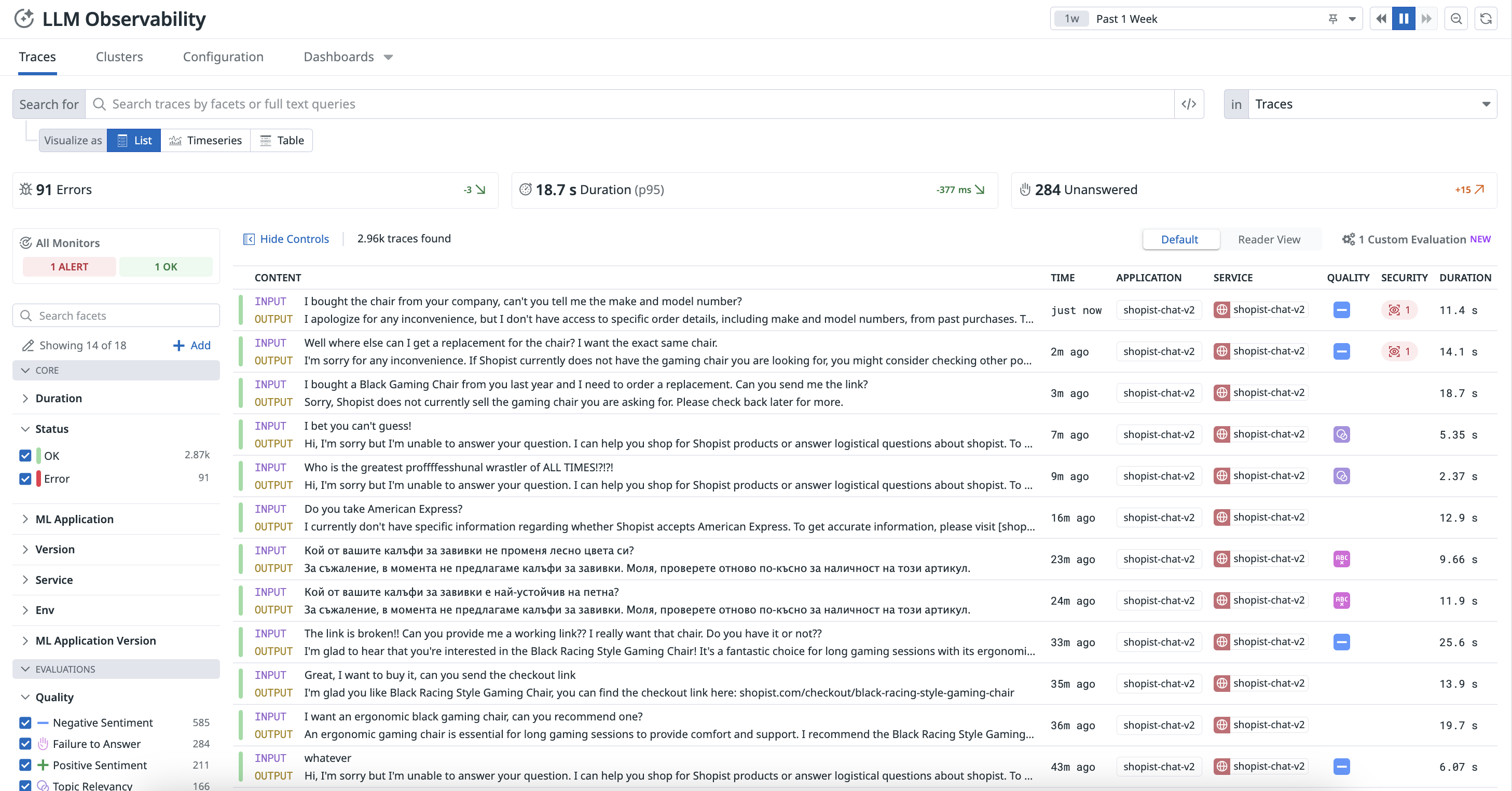

Observabilidad de LLM

LLM Observability no está disponible en el sitio seleccionado () en este momento.

Resumen

Con LLM Observability, puedes monitorizar, solucionar problemas y evaluar tus aplicaciones impulsadas por LLM, como los chatbots. Puedes investigar la causa raíz de los problemas, monitorizar el rendimiento operativo y evaluar la calidad, privacidad y seguridad de tus aplicaciones de LLM.

Cada solicitud realizada por tu aplicación se representa como una traza (trace) en la página de LLM Observability en Datadog.

Un traza puede representar:

- Una inferencia de LLM individual, incluyendo tokens, información de error y latencia.

- Un flujo de trabajo de LLM predeterminado, que es una agrupación de llamadas de LLM y sus operaciones contextuales, como llamadas a herramientas o pasos de preprocesamiento

- Un flujo de trabajo de LLM dinámico ejecutado por un Agent de LLM

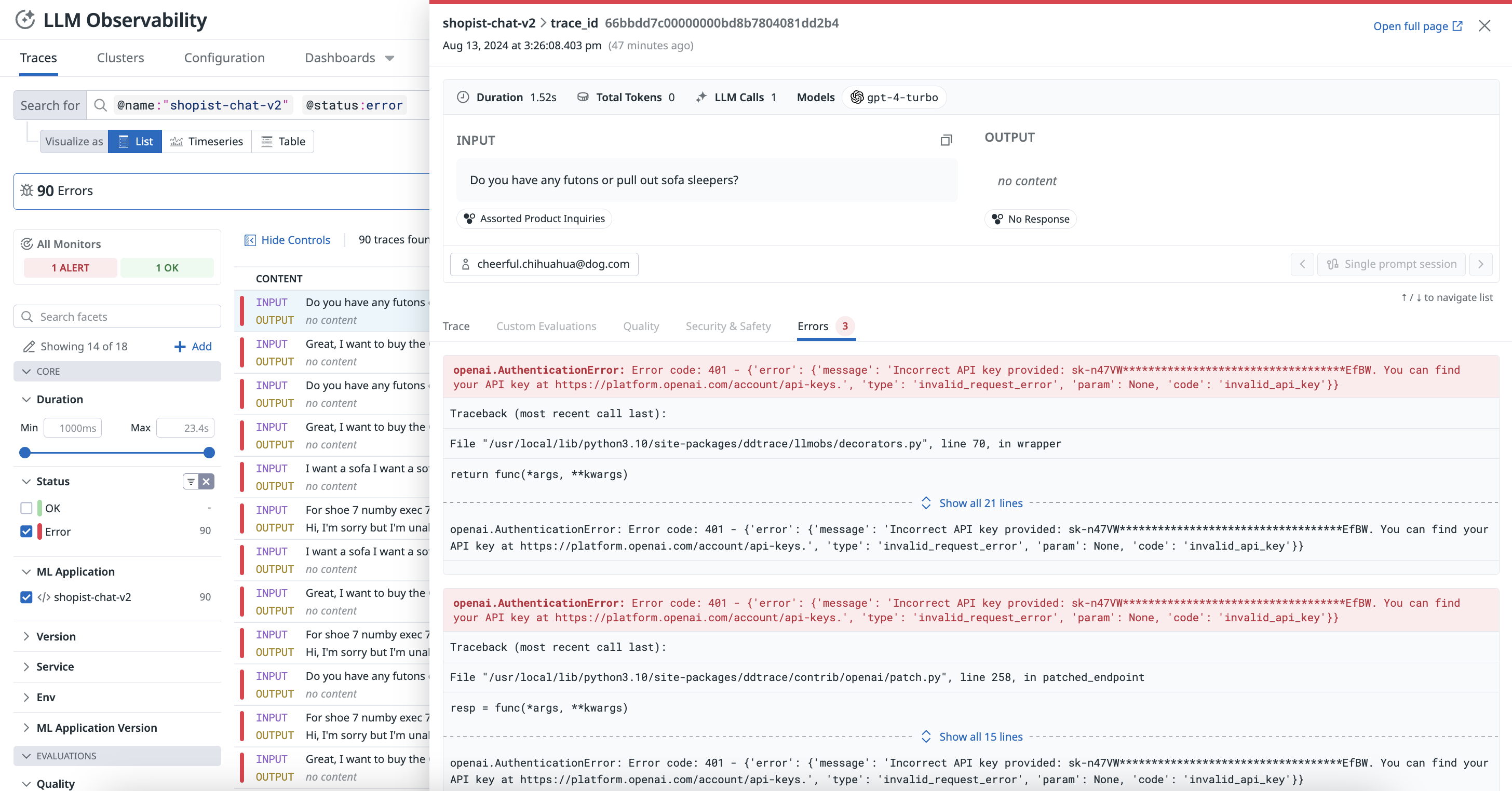

Cada traza contiene tramos (spans) que representan cada elección realizada por un Agent o cada paso de un flujo de trabajo dado. Una traza dada también puede incluir entrada y salida, latencia, problemas de privacidad, errores, etc. Para más información, consulta Términos y conceptos.

Solucionar problemas con el rastreo de extremo a extremo

Visualiza cada paso de las cadenas y llamadas de tu aplicación de LLM para localizar las solicitudes problemáticas e identificar la causa raíz de los errores.

Monitorizar métricas operativas y optimización de costes

Monitoriza el coste, la latencia, el rendimiento y las tendencias de uso de todas tus aplicaciones de LLM con dashboards predefinidos.

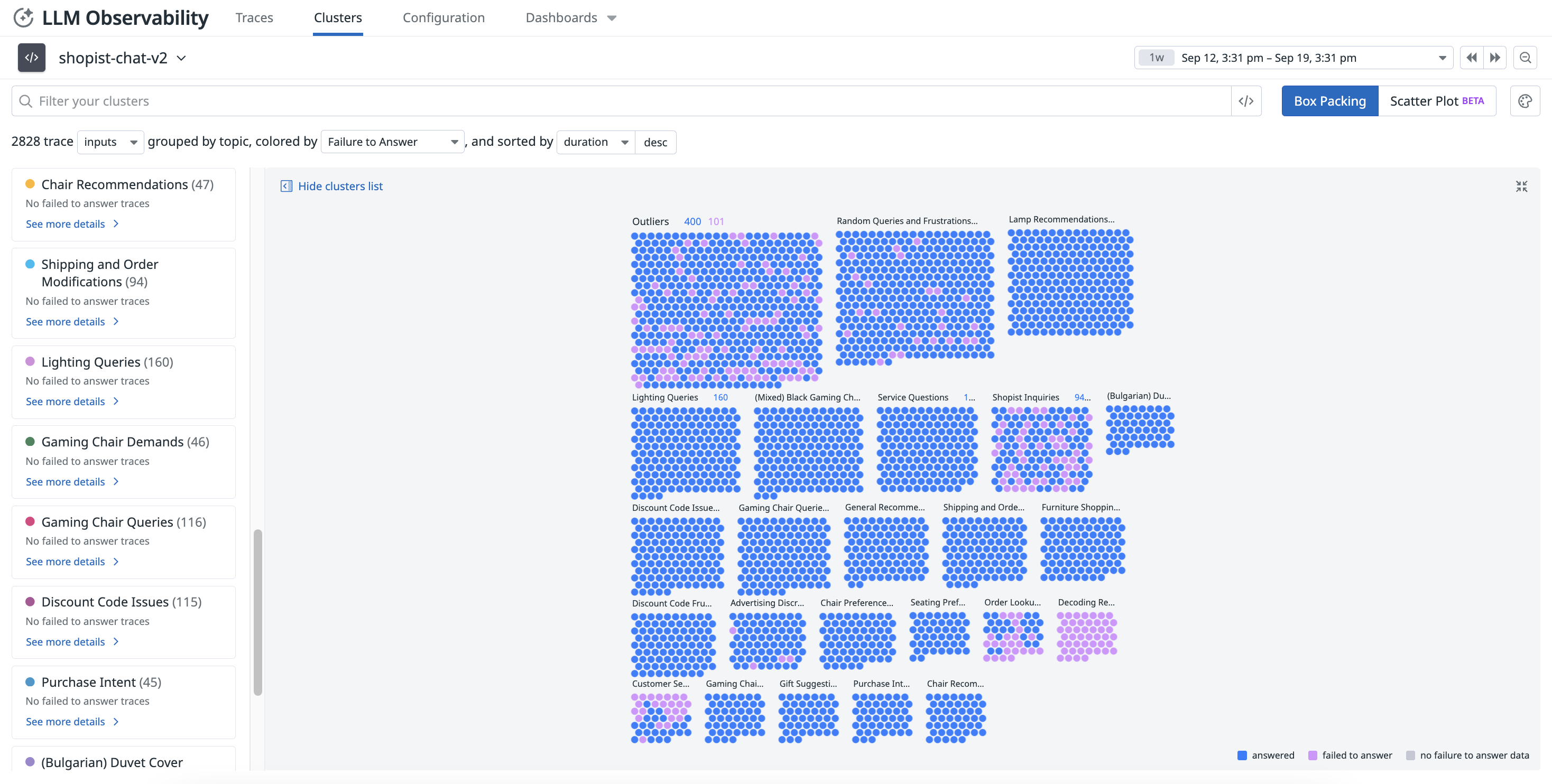

Evaluar la calidad y eficacia de tus aplicaciones de LLM

Identifica los clústeres problemáticas y monitoriza la calidad de las respuestas a lo largo del tiempo con agrupaciones temáticas y checks como sentimiento, falta de respuesta, etc.

Salvaguardar los datos confidenciales e identificar a los usuarios malintencionados

Escanea y redacta automáticamente cualquier dato confidencial en tus aplicaciones de IA e identifica inyecciones de prompts, entre otras evaluaciones.

Utilizar integraciones con LLM Observability

El SDK de LLM Observability para Python se integra con marcos como OpenAI, LangChain, AWS Bedrock y Anthropic. Automáticamente rastrea y anota llamadas a LLM, capturando métricas de latencia, errores y uso de tokens, sin cambios en el código.

Datadog ofrece diversas funciones de inteligencia artificial (IA) y Machine Learning (ML). Las integraciones de IA/ML en la página de integraciones y el Marketplace de Datadog son funcionalidades de toda la plataforma de Datadog. Por ejemplo, APM ofrece una integración nativa con OpenAI para la monitorización de tu uso de OpenAI, mientras que la Monitorización de infraestructura ofrece una integración con NVIDIA DCGM Exporter para monitorizar cargas de trabajo de IA de alto consumo de cómputo. Estas integraciones son diferentes de la oferta de LLM Observability.

Para obtener más información, consulta la documentación de Autoinstrumentación.

¿Estás listo para comenzar?

Consulta la Documentación de configuración para obtener instrucciones sobre cómo instrumentar tu aplicación de LLM o sigue la Guía Rastrear una aplicación de LLM para generar una traza utilizando el SDK de LLM Observability para Python.

Referencias adicionales

Más enlaces, artículos y documentación útiles: