- Esenciales

- Empezando

- Datadog

- Sitio web de Datadog

- DevSecOps

- Serverless para Lambda AWS

- Agent

- Integraciones

- Contenedores

- Dashboards

- Monitores

- Logs

- Rastreo de APM

- Generador de perfiles

- Etiquetas (tags)

- API

- Catálogo de servicios

- Session Replay

- Continuous Testing

- Monitorización Synthetic

- Gestión de incidencias

- Monitorización de bases de datos

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Análisis de código

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Uso básico del Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Configuración remota

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- OpenTelemetry

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un cuadro

- Crear un dashboard de integración

- Crear un monitor recomendado

- Crear una regla de detección Cloud SIEM

- OAuth para integraciones

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- Administrator's Guide

- API

- Aplicación móvil de Datadog

- CoScreen

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Hojas

- Monitores y alertas

- Infraestructura

- Métricas

- Watchdog

- Bits AI

- Catálogo de servicios

- Catálogo de APIs

- Error Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Gestión de eventos

- Gestión de casos

- Workflow Automation

- App Builder

- Infraestructura

- Universal Service Monitoring

- Contenedores

- Serverless

- Monitorización de red

- Coste de la nube

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Observabilidad del servicio

- Instrumentación dinámica

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Experiencia digital

- Real User Monitoring

- Monitorización del navegador

- Configuración

- Configuración avanzada

- Datos recopilados

- Monitorización del rendimiento de páginas

- Monitorización de signos vitales de rendimiento

- Monitorización del rendimiento de recursos

- Recopilación de errores del navegador

- Rastrear las acciones de los usuarios

- Señales de frustración

- Error Tracking

- Solucionar problemas

- Monitorización de móviles y TV

- Plataforma

- Session Replay

- Exploración de datos de RUM

- Feature Flag Tracking

- Error Tracking

- Guías

- Seguridad de los datos

- Monitorización del navegador

- Análisis de productos

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Entrega de software

- CI Visibility

- CD Visibility

- Test Visibility

- Configuración

- Tests en contenedores

- Búsqueda y gestión

- Explorador

- Monitores

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Detección temprana de defectos

- Reintentos automáticos de tests

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- Métricas de DORA

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Sensitive Data Scanner

- Ayuda

Destinos

Información general

Utiliza el worker de pipelines de observabilidad para enviar tus logs procesados a diferentes destinos.

Selecciona y configura tus destinos cuando configures un pipeline. Este es el paso 4 del proceso de configuración de pipelines:

- Ve a Pipelines de observabilidad.

- Selecciona una plantilla.

- Selecciona y configura tu fuente.

- Selecciona y configura tus destinos.

- Configura tus procesadores.

- Instala el worker de pipelines de observabilidad.

Selecciona un destino para obtener más información:

Sintaxis de la plantilla

Los logs suelen almacenarse en índices independientes basados en datos de logs, como el servicio o el entorno de los que proceden los logs u otro atributo de log. En Observability Pipelines, puedes utilizar la sintaxis de plantilla para dirigir tus logs a diferentes índices basados en campos de log específicos.

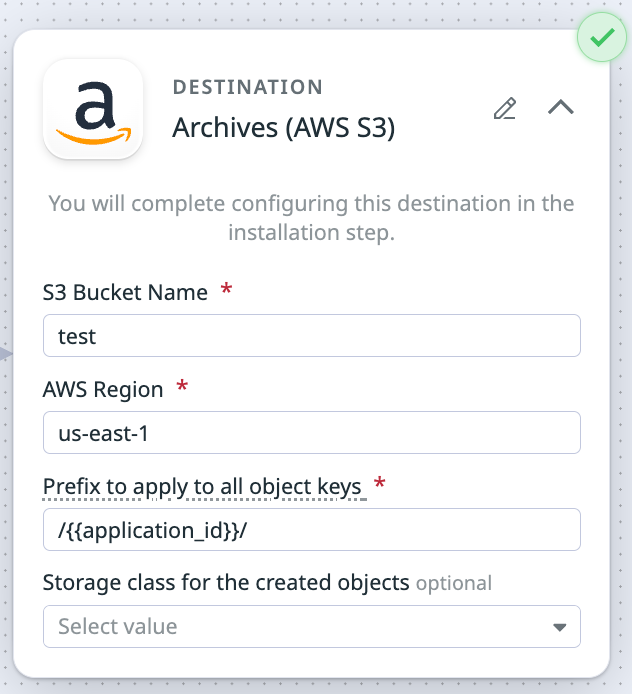

Cuando el worker de Observability Pipelines no puede resolver el campo con la sintaxis de la plantilla, el worker adopta por defecto un comportamiento especificado para ese destino. Por ejemplo, si estás utilizando la plantilla {{application_id}} para el campo Prefix (Prefijo) del destino de Amazon S3, pero no hay un campo application_id en el log, el worker crea una carpeta llamada OP_UNRESOLVED_TEMPLATE_LOGS/ y publica los logs allí.

La siguiente tabla enumera los destinos y campos que admiten la sintaxis de plantilla, y explica qué ocurre cuando el worker no puede resolver el campo:

| Destino | Campos compatibles con la sintaxis de plantilla | Comportamiento cuando no se puede resolver el campo |

|---|---|---|

| Amazon Opensearch | Índice | El worker escribe logs en el índice datadog-op. |

| Amazon S3 | Prefijo | El worker crea una carpeta llamada OP_UNRESOLVED_TEMPLATE_LOGS/ y escribe allí los logs. |

| Azure Blob | Prefijo | El worker crea una carpeta llamada OP_UNRESOLVED_TEMPLATE_LOGS/ y escribe allí los logs. |

| Elasticsearch | Tipo de fuente | El worker escribe logs en el índice datadog-op. |

| Google Chronicle | Tipo de log | Por defecto el tipo de log es DATADOG. |

| Google Cloud | Prefijo | El worker crea una carpeta llamada OP_UNRESOLVED_TEMPLATE_LOGS/ y escribe allí los logs. |

| Opensearch | Índice | El worker escribe logs en el índice datadog-op. |

| Splunk HEC | Índice Tipo de fuente | El worker envía los logs al índice por defecto configurado en Splunk. El worker envía por defecto el tipo de fuente httpevent. |

Ejemplo

Si deseas enrutar logs según el campo de ID de aplicación del log (por ejemplo, application_id) al destino de Amazon S3, utiliza la sintaxis de campos de evento en el campo Prefix to apply to all object keys (Prefijo para aplicar a todas las claves de objeto).

Sintaxis

Campos de evento

Utiliza {{ <field_name> }} para acceder a los campos de evento de logs individuales. Por ejemplo:

{{ application_id }}

Especificadores Strftime

Utiliza especificadores strftime para la fecha y la hora. Por ejemplo:

year=%Y/month=%m/day=%d

Caracteres de escape

Utiliza un prefijo en un carácter con \ para escapar del carácter. En este ejemplo, se escapa la sintaxis del campo de evento:

\{{ field_name }}

Este ejemplo escapa de los especificadores strftime:

year=\%Y/month=\%m/day=\%d/

Colocación de eventos en lotes

Los destinos de los pipelines de observabilidad envían eventos en lotes a la integración aguas abajo. Un lote de eventos se descarga cuando se cumple uno de los siguientes parámetros:

- Número máximo de eventos

- Número máximo de bytes

- Tiempo de espera (segundos)

Por ejemplo, si los parámetros de un destino son:

- Número máximo de eventos = 2

- Número máximo de bytes = 100.000

- Tiempo de espera (segundos) = 5

Y el destino recibe 1 evento en una ventana de 5 segundos, descarga el lote en el tiempo de espera de 5 segundos.

Si el destino recibe 3 eventos en 2 segundos, descarga un lote con 2 eventos y descarga un segundo lote con el evento restante luego de 5 segundos. Si el destino recibe 1 evento que supera los 100.000 bytes, descarga este lote con ese evento.

| Destination | Maximum Events | Maximum Bytes | Timeout (seconds) |

|---|---|---|---|

| Amazon OpenSearch | None | 10,000,000 | 1 |

| Amazon S3 (Datadog Log Archives) | None | 100,000,000 | 900 |

| Amazon Security Lake | None | 256,000,000 | 300 |

| Azure Storage (Datadog Log Archives) | None | 100,000,000 | 900 |

| Datadog Logs | 1,000 | 4,250,000 | 5 |

| Elasticsearch | None | 10,000,000 | 1 |

| Google Chronicle | None | 1,000,000 | 15 |

| Google Cloud Storage (Datadog Log Archives) | None | 100,000,000 | 900 |

| Microsoft Sentinel | None | 10,000,000 | 1 |

| New Relic | 100 | 1,000,000 | 1 |

| OpenSearch | None | 10,000,000 | 1 |

| SentinelOne | None | 1,000,000 | 1 |

| Splunk HTTP Event Collector (HEC) | None | 1,000,000 | 1 |

| Sumo Logic Hosted Collecter | None | 10,000,000 | 1 |

Note: The rsyslog and syslog-ng destinations do not batch events.