- Esenciales

- Empezando

- Datadog

- Sitio web de Datadog

- DevSecOps

- Serverless para Lambda AWS

- Agent

- Integraciones

- Contenedores

- Dashboards

- Monitores

- Logs

- Rastreo de APM

- Generador de perfiles

- Etiquetas (tags)

- API

- Catálogo de servicios

- Session Replay

- Continuous Testing

- Monitorización Synthetic

- Gestión de incidencias

- Monitorización de bases de datos

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Análisis de código

- Centro de aprendizaje

- Compatibilidad

- Glosario

- Atributos estándar

- Guías

- Agent

- Uso básico del Agent

- Arquitectura

- IoT

- Plataformas compatibles

- Recopilación de logs

- Configuración

- Configuración remota

- Automatización de flotas

- Solucionar problemas

- Detección de nombres de host en contenedores

- Modo de depuración

- Flare del Agent

- Estado del check del Agent

- Problemas de NTP

- Problemas de permisos

- Problemas de integraciones

- Problemas del sitio

- Problemas de Autodiscovery

- Problemas de contenedores de Windows

- Configuración del tiempo de ejecución del Agent

- Consumo elevado de memoria o CPU

- Guías

- Seguridad de datos

- Integraciones

- OpenTelemetry

- Desarrolladores

- Autorización

- DogStatsD

- Checks personalizados

- Integraciones

- Crear una integración basada en el Agent

- Crear una integración API

- Crear un pipeline de logs

- Referencia de activos de integración

- Crear una oferta de mercado

- Crear un cuadro

- Crear un dashboard de integración

- Crear un monitor recomendado

- Crear una regla de detección Cloud SIEM

- OAuth para integraciones

- Instalar la herramienta de desarrollo de integraciones del Agente

- Checks de servicio

- Complementos de IDE

- Comunidad

- Guías

- Administrator's Guide

- API

- Aplicación móvil de Datadog

- CoScreen

- Cloudcraft

- En la aplicación

- Dashboards

- Notebooks

- Editor DDSQL

- Hojas

- Monitores y alertas

- Infraestructura

- Métricas

- Watchdog

- Bits AI

- Catálogo de servicios

- Catálogo de APIs

- Error Tracking

- Gestión de servicios

- Objetivos de nivel de servicio (SLOs)

- Gestión de incidentes

- De guardia

- Gestión de eventos

- Gestión de casos

- Workflow Automation

- App Builder

- Infraestructura

- Universal Service Monitoring

- Contenedores

- Serverless

- Monitorización de red

- Coste de la nube

- Rendimiento de las aplicaciones

- APM

- Términos y conceptos de APM

- Instrumentación de aplicación

- Recopilación de métricas de APM

- Configuración de pipelines de trazas

- Correlacionar trazas (traces) y otros datos de telemetría

- Trace Explorer

- Observabilidad del servicio

- Instrumentación dinámica

- Error Tracking

- Seguridad de los datos

- Guías

- Solucionar problemas

- Continuous Profiler

- Database Monitoring

- Gastos generales de integración del Agent

- Arquitecturas de configuración

- Configuración de Postgres

- Configuración de MySQL

- Configuración de SQL Server

- Configuración de Oracle

- Configuración de MongoDB

- Conexión de DBM y trazas

- Datos recopilados

- Explorar hosts de bases de datos

- Explorar métricas de consultas

- Explorar ejemplos de consulta

- Solucionar problemas

- Guías

- Data Streams Monitoring

- Data Jobs Monitoring

- Experiencia digital

- Real User Monitoring

- Monitorización del navegador

- Configuración

- Configuración avanzada

- Datos recopilados

- Monitorización del rendimiento de páginas

- Monitorización de signos vitales de rendimiento

- Monitorización del rendimiento de recursos

- Recopilación de errores del navegador

- Rastrear las acciones de los usuarios

- Señales de frustración

- Error Tracking

- Solucionar problemas

- Monitorización de móviles y TV

- Plataforma

- Session Replay

- Exploración de datos de RUM

- Feature Flag Tracking

- Error Tracking

- Guías

- Seguridad de los datos

- Monitorización del navegador

- Análisis de productos

- Pruebas y monitorización de Synthetics

- Continuous Testing

- Entrega de software

- CI Visibility

- CD Visibility

- Test Visibility

- Configuración

- Tests en contenedores

- Búsqueda y gestión

- Explorador

- Monitores

- Flujos de trabajo de desarrolladores

- Cobertura de código

- Instrumentar tests de navegador con RUM

- Instrumentar tests de Swift con RUM

- Detección temprana de defectos

- Reintentos automáticos de tests

- Correlacionar logs y tests

- Guías

- Solucionar problemas

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- Métricas de DORA

- Seguridad

- Información general de seguridad

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- Observabilidad de la IA

- Log Management

- Observability Pipelines

- Gestión de logs

- Administración

- Gestión de cuentas

- Seguridad de los datos

- Sensitive Data Scanner

- Ayuda

Rastrear una aplicación LLM

LLM Observability no está disponible en el sitio seleccionado () en este momento.

Información general

Esta guía utiliza los SDK de LLM Observability para Python y Node.js. Si tu aplicación está escrita en otro lenguaje, puedes crear trazas (traces) llamando a la API en su lugar.

Configuración

Notebooks Jupyter

Para entender mejor los términos y conceptos de LLM Observability, puedes explorar los ejemplos en el repositorio de notebooks de LLM Observability. Estos notebooks proporcionan una experiencia práctica y te permiten aplicar estos conceptos en tiempo real.

Línea de comandos

Para generar una traza (trace) de LLM Observability, puedes ejecutar un script Python o Node.js.

Requisitos previos

- LLM Observability requiere una clave de API Datadog. Para obtener más información, consulta las instrucciones para crear una clave de API.

- El siguiente script de ejemplo utiliza OpenAI, pero puedes modificarlo para utilizar un proveedor diferente. Para ejecutar el script tal y como está escrito, necesitas:

- Una clave de API OpenAI almacenada en tu entorno como

OPENAI_API_KEY. Para crear una, consulta la configuración de la cuenta y Configurar tu clave de API en la documentación oficial de OpenAI. - Biblioteca OpenAI Python instalada. Para obtener instrucciones, consulta la configuración de Python en la documentación oficial de OpenAI.

- Una clave de API OpenAI almacenada en tu entorno como

Instala los paquetes de SDK y OpenAI:

pip install ddtrace pip install openaiCrea un script, que hace una única llamada a OpenAI.

import os from openai import OpenAI oai_client = OpenAI(api_key=os.environ.get("OPENAI_API_KEY")) completion = oai_client.chat.completions.create( model="gpt-3.5-turbo", messages=[ {"role": "system", "content": "You are a helpful customer assistant for a furniture store."}, {"role": "user", "content": "I'd like to buy a chair for my living room."}, ], )Ejecuta el script con el siguiente comando shell. Esto envía una traza de la llamada de OpenAI a Datadog.

DD_LLMOBS_ENABLED=1 DD_LLMOBS_ML_APP=onboarding-quickstart \ DD_API_KEY=<YOUR_DATADOG_API_KEY> DD_SITE=<YOUR_DD_SITE> \ DD_LLMOBS_AGENTLESS_ENABLED=1 ddtrace-run python quickstart.pySustituye

<YOUR_DATADOG_API_KEY>por tu clave de API Datadog y<YOUR_DD_SITE>por tu sitio Datadog.Para obtener más información sobre las variables de entorno necesarias, consulta la documentación del SDK.

Instala los paquetes de SDK y OpenAI:

npm install dd-trace npm install openaiCrea un script, que hace una única llamada a OpenAI.

const { OpenAI } = require('openai'); const oaiClient = new OpenAI(process.env.OPENAI_API_KEY); function main () { const completion = await oaiClient.chat.completions.create({ model: 'gpt-3.5-turbo', messages: [ { role: 'system', content: 'You are a helpful customer assistant for a furniture store.' }, { role: 'user', content: 'I\'d like to buy a chair for my living room.' }, ] }); } main();Ejecuta el script con el siguiente comando shell. Esto envía una traza de la llamada de OpenAI a Datadog.

DD_LLMOBS_ENABLED=1 DD_LLMOBS_ML_APP=onboarding-quickstart \ DD_API_KEY=<YOUR_DATADOG_API_KEY> DD_SITE=<YOUR_DD_SITE> \ DD_LLMOBS_AGENTLESS_ENABLED=1 NODE_OPTIONS="--import dd-trace/initialize.mjs" node quickstart.jsSustituye

<YOUR_DATADOG_API_KEY>por tu clave de API Datadog y<YOUR_DD_SITE>por tu sitio Datadog.Para obtener más información sobre las variables de entorno necesarias, consulta la documentación del SDK.

Nota: DD_LLMOBS_AGENTLESS_ENABLED sólo es necesaria si no se está ejecutando el Datadog Agent. Si el Agent se está ejecutando en tu entorno de producción, asegúrate de que esta variable de entorno no está configurada.

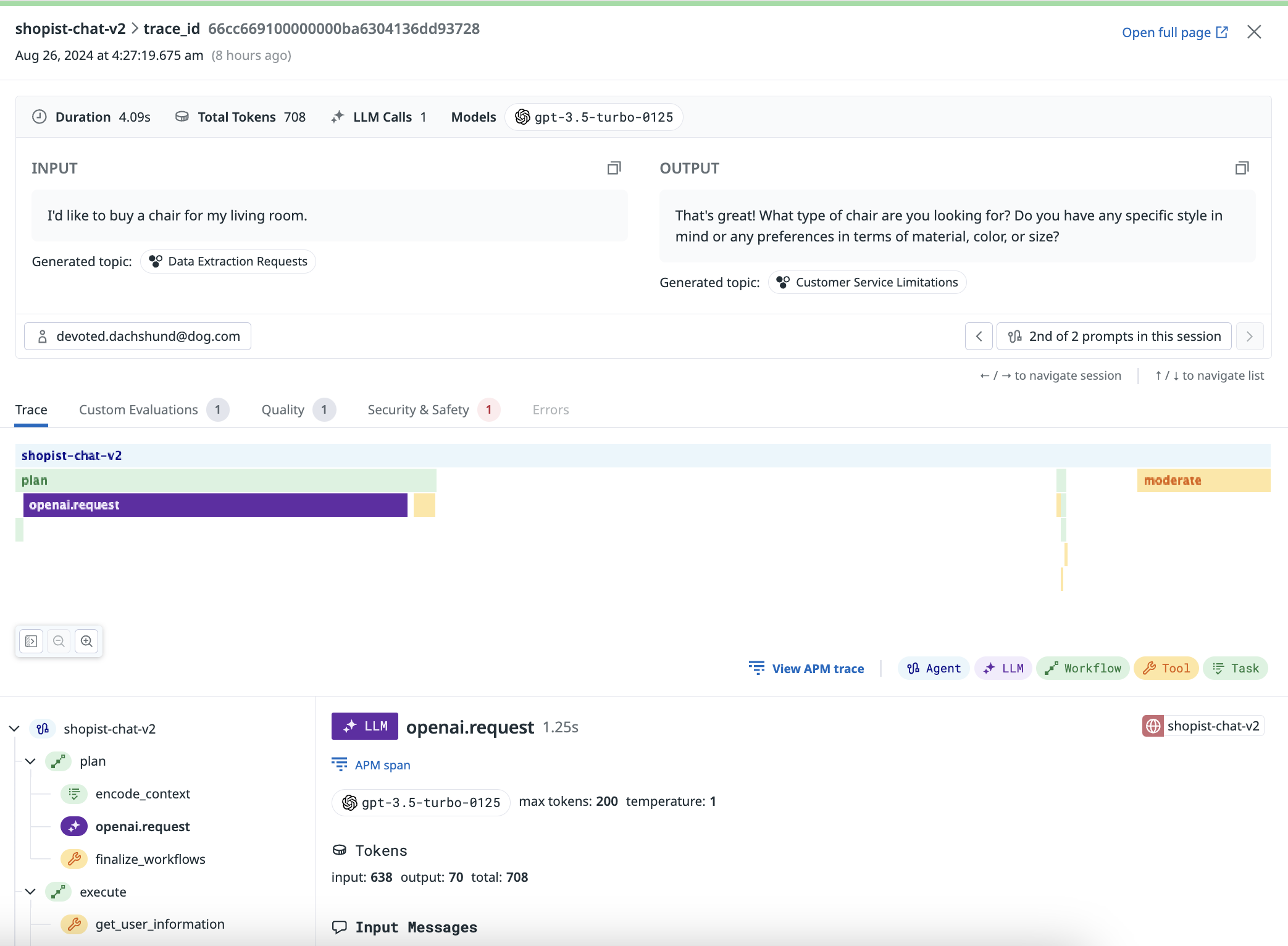

Consulta la traza de tu llamada LLM en la pestaña Trazas de la página LLM Observability en Datadog.

La traza que ves se compone de un único tramo (span) LLM. El comando ddtrace-run o NODE_OPTIONS="--import dd-trace/initialize.mjs" automáticamente rastrea tus llamadas LLM desde la lista de integraciones compatibles de Datadog.

Si tu aplicación incluye avisos, cadenas complejas o flujos de trabajo más elaborados que involucran LLM, puedes rastrearlos utilizando la documentación de configuración y la documentación del SDK.

Referencias adicionales

Más enlaces, artículos y documentación útiles: