- 重要な情報

- はじめに

- Datadog

- Datadog サイト

- DevSecOps

- AWS Lambda のサーバーレス

- エージェント

- インテグレーション

- コンテナ

- ダッシュボード

- アラート設定

- ログ管理

- トレーシング

- プロファイラー

- タグ

- API

- Service Catalog

- Session Replay

- Continuous Testing

- Synthetic モニタリング

- Incident Management

- Database Monitoring

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Code Analysis

- Learning Center

- Support

- 用語集

- Standard Attributes

- ガイド

- インテグレーション

- エージェント

- OpenTelemetry

- 開発者

- 認可

- DogStatsD

- カスタムチェック

- インテグレーション

- Create an Agent-based Integration

- Create an API Integration

- Create a Log Pipeline

- Integration Assets Reference

- Build a Marketplace Offering

- Create a Tile

- Create an Integration Dashboard

- Create a Recommended Monitor

- Create a Cloud SIEM Detection Rule

- OAuth for Integrations

- Install Agent Integration Developer Tool

- サービスのチェック

- IDE インテグレーション

- コミュニティ

- ガイド

- API

- モバイルアプリケーション

- CoScreen

- Cloudcraft

- アプリ内

- Service Management

- インフラストラクチャー

- アプリケーションパフォーマンス

- APM

- Continuous Profiler

- データベース モニタリング

- Data Streams Monitoring

- Data Jobs Monitoring

- Digital Experience

- Software Delivery

- CI Visibility (CI/CDの可視化)

- CD Visibility

- Test Visibility

- Intelligent Test Runner

- Code Analysis

- Quality Gates

- DORA Metrics

- セキュリティ

- セキュリティの概要

- Cloud SIEM

- クラウド セキュリティ マネジメント

- Application Security Management

- AI Observability

- ログ管理

- Observability Pipelines(観測データの制御)

- ログ管理

- 管理

Observability Pipelines(観測データの制御)

Observability Pipelines は、US1-FED Datadog サイトでは使用できません。

Datadog は、Observability Pipelines Worker (OPW) を、すべてのマイナーリリースおよびパッチリリースごと、または最低でも月次で更新することを推奨しています。

OPW の最新の機能、修正、およびセキュリティアップデートを入手するための唯一のサポートされている方法は、OPW をメジャーバージョンにアップグレードし、常に最新の状態に保つことです。

OPW の最新の機能、修正、およびセキュリティアップデートを入手するための唯一のサポートされている方法は、OPW をメジャーバージョンにアップグレードし、常に最新の状態に保つことです。

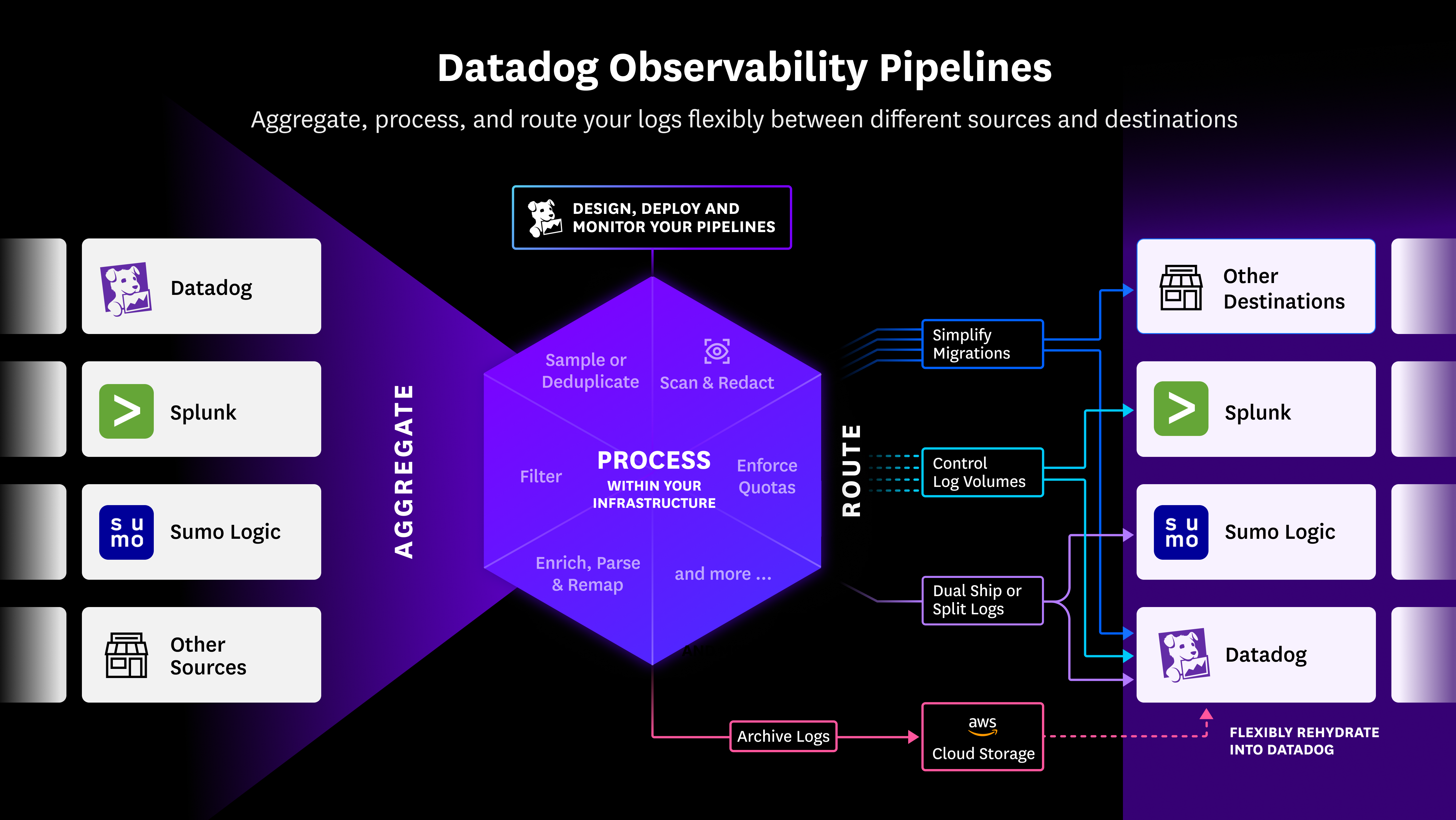

概要

Observability Pipelines を使用すると、独自のインフラストラクチャーでログを収集、処理、ルーティングできます。すぐに使えるテンプレートが提供されているため、簡単にパイプラインを構築してデプロイできます。

Observability Pipelines Worker は、インフラストラクチャー上で動作するソフトウェアで、ユースケースに基づいてログを一元的に集計、処理、ルーティングします。これにより、ログが環境を離れる前に機密データのマスキングやログの前処理を行ったり、ログの宛先を決定したりすることができます。

Observability Pipelines UI は、Observability Pipelines Worker を管理するためのコントロールプレーンを提供し、パイプラインの構築や編集、パイプラインの変更の Worker へのデプロイが可能です。また、すぐに使えるモニターを有効にして、パイプラインの健全性を評価することもできます。

詳細はこちら

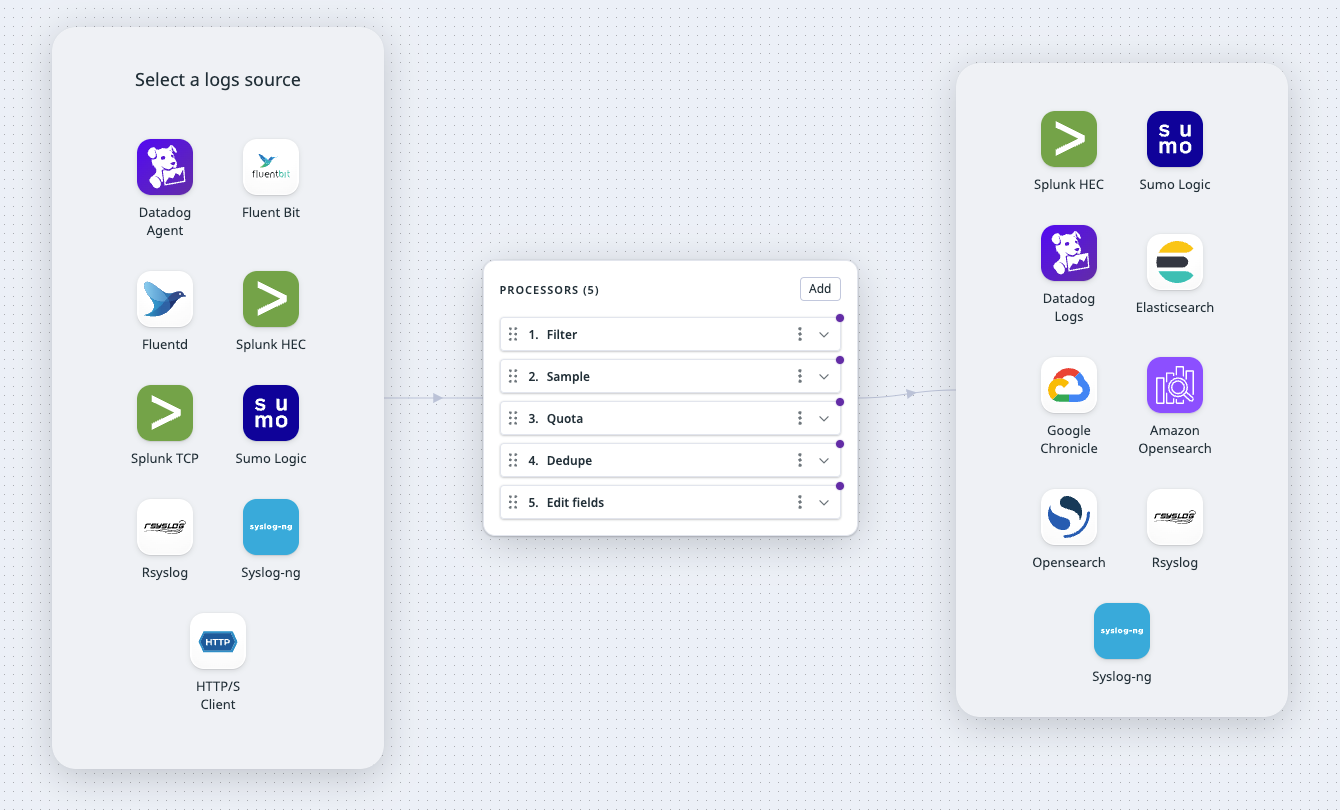

パイプラインをセットアップするには

- Observability Pipelines に移動します。

- テンプレートを選択します。

- [ログボリュームコントロール][2]

- ログのデュアルシッピング

- [ログの分割][4]

- Datadog アーカイブにログをアーカイブ

- [機密データのマスキング][6]

- [ログエンリッチメント][7]

- Select and set up your source.

- Select and set up your destinations.

- Set up you processors.

- Observability Pipelines Worker をインストールします。

- パイプラインのモニターを有効にします。

詳細については、パイプラインのセットアップを参照してください。

ブートストラップオプションや Kubernetes での Worker のセットアップの詳細については、高度な構成を参照してください。

Observability Pipelines の探索

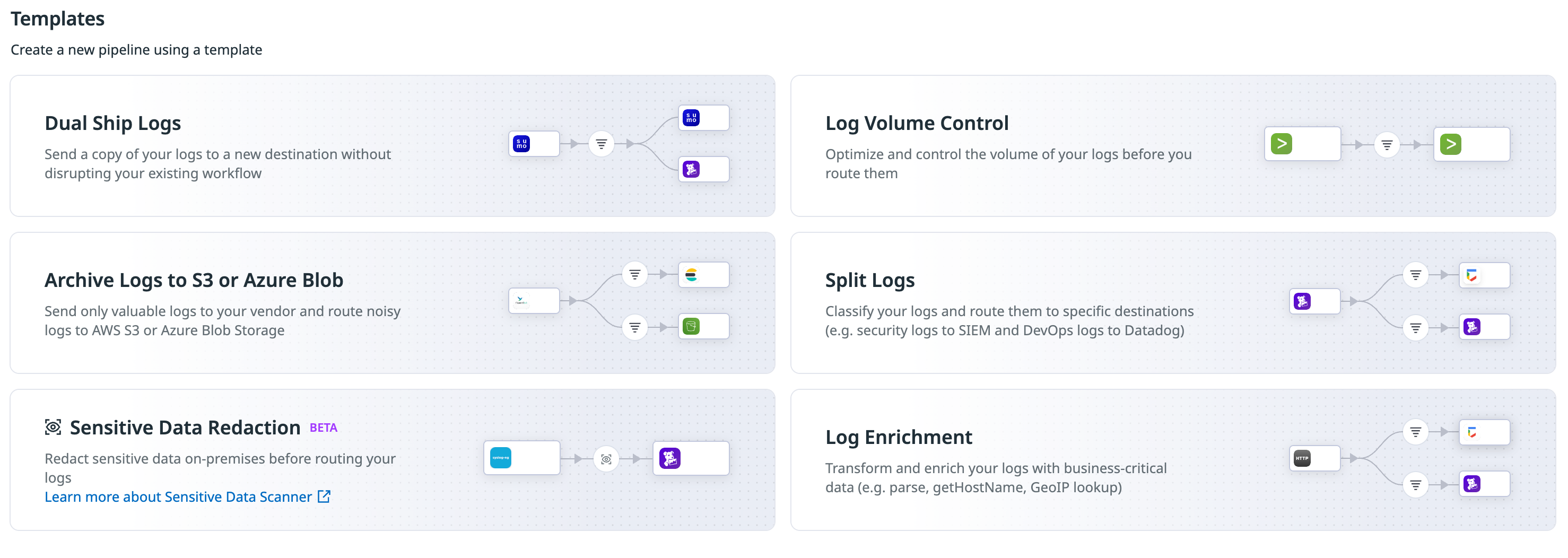

すぐに使えるテンプレートでパイプラインを構築

テンプレートは以下のユースケースを想定して作られています。

ログボリューム制御

生ログはノイズが多く、調査時の検索や分析に有用なものは限られています。 Log Volume Control テンプレートを使用して、SIEM やログ管理ソリューションなどのインデックス化ソリューションに送信するログを決定することで、インデックス化されたログの価値を高め、予算内に収めることができます。

デュアルシップログ

組織が成長するにつれて、セキュリティ、アーカイブ、ログ管理など、さまざまなユースケースに対する可観測性のニーズも変化します。これにより、異なるアーカイブ、SIEM、ログ管理ソリューションを試す必要が生じるかもしれません。しかし、異なるソリューションへのログパイプラインの管理は複雑になる可能性があります。Dual Ship Logs テンプレートを使用すれば、ログを一元的に集計、処理し、異なる宛先へコピーを送信することで、この管理を簡素化できます。

アーカイブログ

Archive Logs テンプレートを使用して、ログをクラウドストレージソリューション (Amazon S3、Google Cloud Storage、または Azure Storage) に保存します。アーカイブされたログは Datadog で再利用可能な形式で保存されるため、必要に応じて Datadog で再利用できます。これは、以下の場合に有用です。

- 大量のノイズを含むログがあっても、調査のために随時 Datadog Log Management でインデックス化が必要な場合

- Datadog Log Management への移行中で、移行完了後に履歴ログを保持したい場合

- コンプライアンス要件を満たすために保持ポリシーがあるが、それらのログを必ずしもインデックス化する必要がない場合

ログの分割

異なるサービスやアプリケーションから生成されたログを、クエリ、分析、アラートのために異なるダウンストリームサービスに送信する必要がある場合。例えば、セキュリティログを SIEM ソリューションに、DevOps ログを Datadog に送信したい場合です。Split Logs テンプレートを使用して、ログを宛先ごとに個別に前処理してから送信します。

機密データのマスキング

Sensitive Data Redaction テンプレートを使用して、オンプレミスで機密情報を検出しマスキングします。Observability Pipelines の機密データスキャナプロセッサは、70 のすぐに使えるスキャンルールを提供しますが、正規表現を使用して独自のカスタムスキャンルールを作成することも可能です。すぐに使えるルールは、クレジットカード番号、メールアドレス、IP アドレス、API キー、SSH キー、アクセストークンなどの標準的なパターンを認識します。

ログエンリッチメント

組織内のさまざまなサービス、システム、アプリケーションは、多層の情報を含むログを異なる形式で生成します。これにより、調査時に必要なデータを検索・分析する際に、データの抽出が難しくなることがあります。 Log Enrichment テンプレートを使用して、ログを標準化し、リファレンステーブルなどの情報で充実化します。

Observability Pipelines UI でパイプラインを構築する

Observability Pipelines UI でパイプラインを構築します。すぐに使えるテンプレートを選択すると、オンボーディングワークフローがソース、プロセッサ、宛先のセットアップをガイドします。インストールページでは、Docker、Kubernetes、Linux、または CloudFormation を用いた環境での Worker のインストール方法が説明されています。

パイプラインコンポーネントのすぐに使えるモニターを有効にする

パイプライン作成後、すぐに使えるモニターを有効にして、次の場合にアラートを受け取れるようにします、

- コンポーネントのエラー率が増加している場合。これは、予期しない形式のデータ処理が原因で発生することがあります。

- Observability Pipelines Worker の CPU 使用率やメモリ使用率が高い場合。

- コンポーネントによってデータが急激にドロップされている場合。

その他の参考資料

お役に立つドキュメント、リンクや記事:

ログ収集とインテグレーションドキュメント

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()

![more]()