- Principales informations

- Getting Started

- Datadog

- Site Datadog

- DevSecOps

- Serverless for AWS Lambda

- Agent

- Intégrations

- Conteneurs

- Dashboards

- Monitors

- Logs

- Tracing

- Profileur

- Tags

- API

- Service Catalog

- Session Replay

- Continuous Testing

- Surveillance Synthetic

- Incident Management

- Database Monitoring

- Cloud Security Management

- Cloud SIEM

- Application Security Management

- Workflow Automation

- CI Visibility

- Test Visibility

- Intelligent Test Runner

- Code Analysis

- Learning Center

- Support

- Glossary

- Standard Attributes

- Guides

- Agent

- Intégrations

- OpenTelemetry

- Développeurs

- Authorization

- DogStatsD

- Checks custom

- Intégrations

- Create an Agent-based Integration

- Create an API Integration

- Create a Log Pipeline

- Integration Assets Reference

- Build a Marketplace Offering

- Create a Tile

- Create an Integration Dashboard

- Create a Recommended Monitor

- Create a Cloud SIEM Detection Rule

- OAuth for Integrations

- Install Agent Integration Developer Tool

- Checks de service

- IDE Plugins

- Communauté

- Guides

- API

- Application mobile

- CoScreen

- Cloudcraft

- In The App

- Dashboards

- Notebooks

- DDSQL Editor

- Alertes

- Infrastructure

- Métriques

- Watchdog

- Bits AI

- Service Catalog

- API Catalog

- Error Tracking

- Service Management

- Infrastructure

- Universal Service Monitoring

- Conteneurs

- Sans serveur

- Surveillance réseau

- Cloud Cost

- Application Performance

- APM

- Profileur en continu

- Database Monitoring

- Agent Integration Overhead

- Setup Architectures

- Configuration de Postgres

- Configuration de MySQL

- Configuration de SQL Server

- Setting Up Oracle

- Setting Up MongoDB

- Connecting DBM and Traces

- Données collectées

- Exploring Database Hosts

- Explorer les métriques de requête

- Explorer des échantillons de requêtes

- Dépannage

- Guides

- Data Streams Monitoring

- Data Jobs Monitoring

- Digital Experience

- RUM et Session Replay

- Product Analytics

- Surveillance Synthetic

- Continuous Testing

- Software Delivery

- CI Visibility

- CD Visibility

- Test Visibility

- Exécuteur de tests intelligent

- Code Analysis

- Quality Gates

- DORA Metrics

- Securité

- Security Overview

- Cloud SIEM

- Cloud Security Management

- Application Security Management

- AI Observability

- Log Management

- Pipelines d'observabilité

- Log Management

- Administration

FluentD

Supported OS

Intégration2.1.0

Présentation

Obtenez des métriques de Fluentd pour :

- Visualiser les performances Fluentd

- Corréler les performances de Fluentd avec le reste de vos applications

Configuration

Installation

Le check Fluentd est inclus avec le package de l’Agent Datadog : vous n’avez donc rien d’autre à installer sur vos serveurs FluentD.

Préparer Fluentd

Dans votre fichier de configuration Fluentd, ajoutez une source monitor_agent :

<source>

@type monitor_agent

bind 0.0.0.0

port 24220

</source>

Configuration

Host

Pour configurer ce check lorsque l’Agent est exécuté sur un host :

Collecte de métriques

Modifiez le fichier

fluentd.d/conf.yamldans le dossierconf.d/à la racine du répertoire de configuration de votre Agent pour commencer à recueillir vos métriques Fluentd. Consultez le fichier d’exemple fluentd.d/conf.yaml pour découvrir toutes les options de configuration disponibles.init_config: instances: ## @param monitor_agent_url - string - required ## Monitor Agent URL to connect to. # - monitor_agent_url: http://example.com:24220/api/plugins.json

Collecte de logs

Vous pouvez utiliser le plug-in FluentD de Datadog pour transférer directement les logs depuis Fluentd vers votre compte Datadog.

Ajouter des métadonnées à vos logs

Pour tirer pleinement parti de vos logs dans Datadog, vous devez pouvoir compter sur des métadonnées pertinentes (notamment, le hostname et la source). Normalement, les champs hostname et timestamp sont correctement remappés par défaut grâce au remappage d’attributs réservés.

Tag source et tags personnalisés

Ajoutez l’attribut ddsource avec le nom de l’intégration de logs dans vos logs afin de déclencher la configuration automatique de l’intégration dans Datadog.

Les tags host sont automatiquement définis dans vos logs si un hostname correspond à une entrée de votre liste des infrastructures. Utilisez l’attribut ddtags pour ajouter des tags personnalisés à vos logs :

Exemple de configuration :

# Associer les événements avec le tag "datadog.**" et

# les envoyer à Datadog

<match datadog.**>

@type datadog

@id awesome_agent

api_key <votre_clé_api>

# Facultatif

include_tag_key true

tag_key 'tag'

# Tags facultatifs

dd_source '<NOM_INTÉGRATION>'

dd_tags '<KEY1:VALUE1>,<KEY2:VALUE2>'

<buffer>

@type memory

flush_thread_count 4

flush_interval 3s

chunk_limit_size 5m

chunk_limit_records 500

</buffer>

</match>

Par défaut, le plug-in est configuré de façon à envoyer des logs via HTTPS (port 443) à l’aide de la compression gzip. Vous pouvez modifier ce comportement avec les paramètres suivants :

use_http: définissez ce paramètre surfalsepour utiliser la connexion TCP. Vous devez modifier les paramètreshostetporten conséquence. Valeur par défaut :true.use_compression: la compression est uniquement disponible pour les transmissions HTTP. Définissez ce paramètre surfalsepour la désactiver. Valeur par défaut :true.compression_level: définissez le niveau de compression via HTTP. Choisissez une valeur entre 1 (ratio le plus faible) et 9 (ratio le plus élevé). Valeur par défaut :6.

Il est possible d’utiliser des paramètres supplémentaires pour changer l’endpoint utilisé afin de passer par un proxy :

host: l’endpoint proxy pour les logs qui ne sont pas directement transmis à Datadog. Valeur par défaut :http-intake.logs.datadoghq.com.port: le port proxy pour les logs qui ne sont pas directement transmis à Datadog. Valeur par défaut :80.ssl_port: le port utilisé pour les logs transmis via une connexion TCP/SSL sécurisée à Datadog. Valeur par défaut :443.use_ssl: indique à l’Agent d’initialiser une connexion TCP/SSL sécurisée vers Datadog. Valeur par défaut :true.no_ssl_validation: désactive la validation du hostname SSL. Valeur par défaut :false.

Remarque : définissez host et port sur votre région .

<match datadog.**>

#...

host 'http-intake.logs.datadoghq.eu'

</match>

Tags Kubernetes et Docker

Les tags Datadog s’avèrent indispensables pour passer d’une partie du produit à une autre. De la même façon, il est crucial d’associer des métadonnées pertinentes à vos logs pour passer de la vue d’un conteneur ou de métriques de conteneur aux logs connexes.

Si vos logs contiennent un ou plusieurs des attributs suivants, ces attributs sont automatiquement ajoutés en tant que tags Datadog à vos logs :

kubernetes.container_imagekubernetes.container_namekubernetes.namespace_namekubernetes.pod_namedocker.container_id

Bien que l’Agent Datadog recueille automatiquement les métadonnées Docker et Kubernetes, FluentD doit utiliser un plug-in pour y parvenir. Datadog vous conseille d’utiliser fluent-plugin-kubernetes_metadata_filter pour recueillir ces métadonnées.

Exemple de configuration :

# Recueillir les métadonnées des logs avec le tag "kubernetes.**"

<filter kubernetes.*>

type kubernetes_metadata

</filter>

Environnement conteneurisé

Consultez la documentation relative aux modèles d’intégration Autodiscovery pour découvrir comment appliquer les paramètres ci-dessous à un environnement conteneurisé.

Collecte de métriques

| Paramètre | Valeur |

|---|---|

<NOM_INTÉGRATION> | fluentd |

<CONFIG_INIT> | vide ou {} |

<CONFIG_INSTANCE> | {"monitor_agent_url": "http://%%host%%:24220/api/plugins.json"} |

Validation

Lancez la sous-commande status de l’Agent et cherchez fluentd dans la section Checks.

Données collectées

Métriques

| fluentd.buffer_available_buffer_space_ratios (gauge) | Show available space for buffer |

| fluentd.buffer_queue_byte_size (gauge) | Current bytesize of queued buffer chunks Shown as byte |

| fluentd.buffer_queue_length (gauge) | The length of the buffer queue for this plugin. Shown as buffer |

| fluentd.buffer_stage_byte_size (gauge) | Current bytesize of staged buffer chunks Shown as byte |

| fluentd.buffer_stage_length (gauge) | The length of staged buffer chunks |

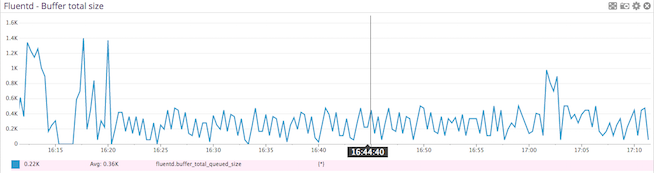

| fluentd.buffer_total_queued_size (gauge) | The size of the buffer queue for this plugin. Shown as byte |

| fluentd.emit_count (gauge) | The total number of emit call in output plugin Shown as unit |

| fluentd.emit_records (gauge) | The total number of emitted records Shown as record |

| fluentd.flush_time_count (gauge) | The total time of buffer flush in milliseconds Shown as millisecond |

| fluentd.retry_count (gauge) | The number of retries for this plugin. Shown as time |

| fluentd.rollback_count (gauge) | The total number of rollback. rollback happens when write/try_write failed Shown as unit |

| fluentd.slow_flush_count (gauge) | The total number of slow flush. This count will be incremented when buffer flush is longer than slowflushlog_threshold Shown as unit |

| fluentd.write_count (gauge) | The total number of write/try_write call in output plugin Shown as unit |

Événements

Le check Fluentd n’inclut aucun événement.

Checks de service

fluentd.is_ok

Renvoie OK si fluentd et son agent de surveillance sont en cours d’exécution. Si ce n’est pas le cas, renvoie CRITICAL.

Statuses: ok, critical

Dépannage

Besoin d’aide ? Contactez l’assistance Datadog.